Meta社は11月19日に画像解析分野で新たなモデル群を公開しました。

発表されたのは高精度な画像セグメンテーションを行う「SegmentAnythingModel3(SAM3)」と、1枚の画像から立体データを生成する「SAM3D」です。

モデリーで世界の魅せ方を再構築する

モデリーは幅広い用途の3Dコンテンツを制作するチームです。

プリレンダリングによる3DCG表現とリアルタイムレンダリングの両面からアプローチし、映像・ゲーム・Webなど多様な媒体で、クライアントのビジュアル表現を支えています。

モデリーは、高精度な3Dモデリング技術を核に、

プリレンダリングからリアルタイム、さらにはAR/VRなどのバーチャルプラットフォームまで、

多様な領域で“次元の高いリッチな体験”を創出しています。

キャラクター、背景、プロダクト、建築、VFXアセットなど、

ジャンルを問わず最適な形で再現・表現できる確かな造形力と技術力が強みです。

2000件を超える制作実績と、目的に応じた柔軟な提案力・対応力により、

多くのクライアントから信頼をいただいています。

3DCG制作、リアルタイムコンテンツ、VR/ARなどに関するご相談・ご依頼は、

ぜひお気軽にお問い合わせください。

GitHub上ではソースコードが入手できますが、利用条件に応じて「SAM3」本体と「SAM3DBody」「SAM3DObjects」が区分管理されています。

学習データはHuggingFaceで提供されており、MetaAIのデモ環境「MetaAIDemos」ではブラウザからSAM3Dの動作を試せます。

Introducing SAM 3D, the newest addition to the SAM collection, bringing common sense 3D understanding of everyday images. SAM 3D includes two models:

— AI at Meta (@AIatMeta) November 19, 2025

🛋️ SAM 3D Objects for object and scene reconstruction

🧑🤝🧑 SAM 3D Body for human pose and shape estimation

Both models achieve… pic.twitter.com/jLpBX2cY9P

Metaが展開するコンピュータビジョン基盤モデル「SegmentAnythingModel(SAM)」は進化を続けており、第3世代となる「SAM3」では、単純なカテゴリ名だけでなく「赤いストライプの傘」のような自然言語による複雑な記述に対しても対象を切り出せるようになりました。

この高精度な認識技術を3D復元に応用したものが「SAM3D」です。

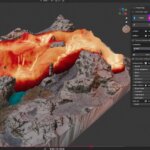

SAM3Dは1枚の写真から物体の立体形状やポーズ、質感までを数秒で再構築します。

多くの画像を前提とした従来のフォトグラメトリとは異なり、推論によって見えない部分を補いながら3D化できる点が大きな特徴です。

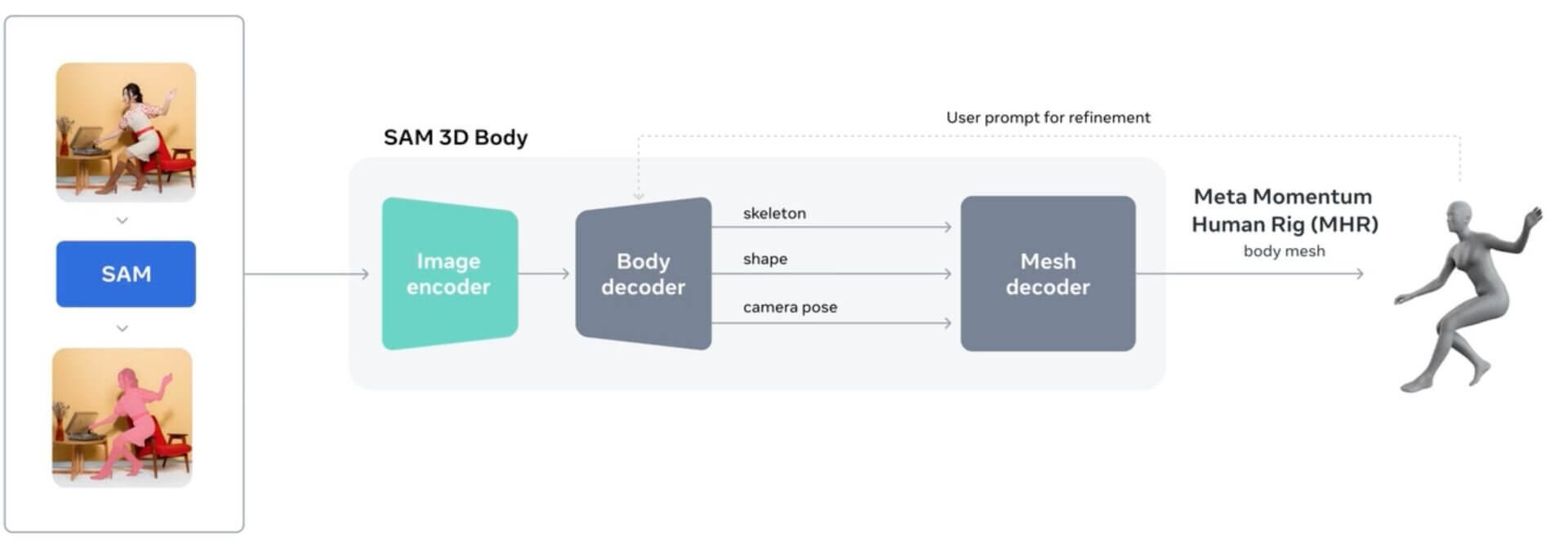

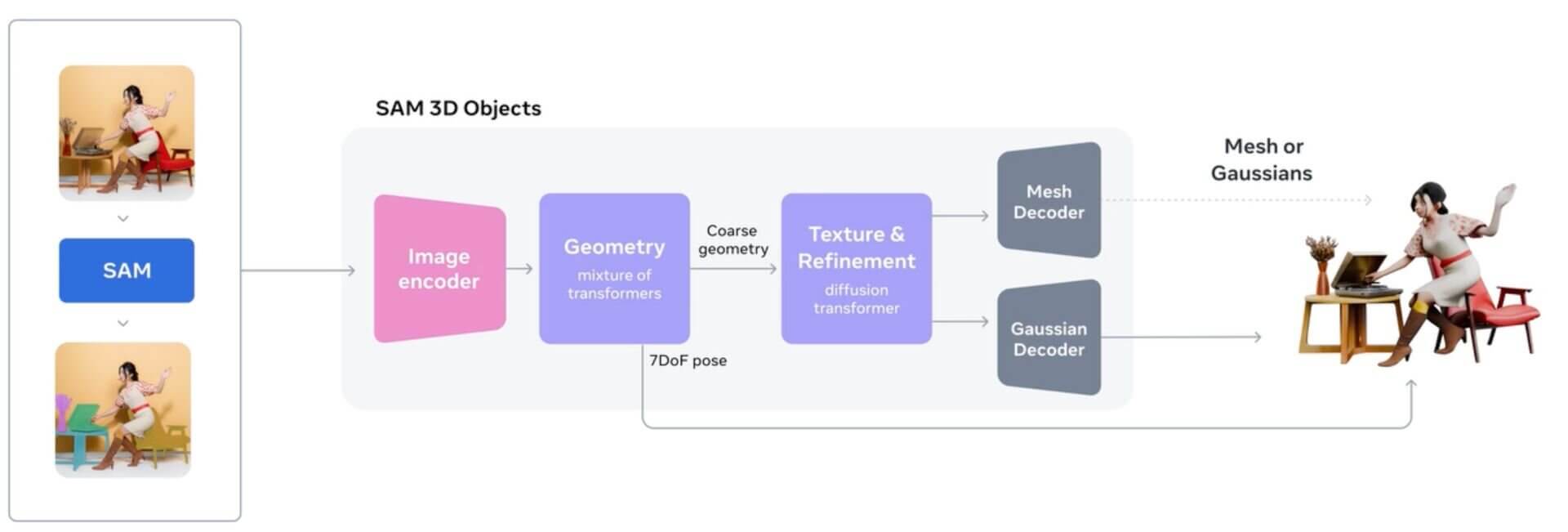

構成は2種類で、人物を対象に体型や骨格、姿勢を高精度にメッシュ化する「SAM3DBody」と、家具・雑貨・自然物といった幅広い一般物体を立体化する「SAM3DObjects」で構成されています。

SAM3のセグメンテーション能力を活かし、画像内から対象だけを丁寧に切り出したうえでメッシュ化を行い、生成されるテクスチャには影の表現も焼き込まれます。

SAM3DBodyの中心となる技術は、骨格と表面形状を分離して扱う独自のパラメトリックモデル「MomentumHumanRig(MHR)」です。

また、SAMのプロンプト入力にも対応し、2Dキーポイントやマスクを使った補助入力が可能になっています。

ユーザーは複雑なポーズや複数人が写るシーンでも、推論結果を対話的に調整しながら望む形で3D復元を進められます。

SAM 3D Objectsの特徴・概要

SAM3DObjectsは、大規模な合成データで事前学習したモデルに、人間の確認を交えた実データでの微調整を段階的に重ねる仕組みが特徴です。

学習工程を複数段階で構築することで、良質な3D素材が十分に揃わない状況でも精度を保ちつつ、複雑な遮蔽や背景ノイズを含む実写画像から文脈を読み取り、見えない領域まで立体形状を補完できるようになります。

SAM 3D enables accurate 3D reconstruction from a single image, supporting real-world applications in editing, robotics, and interactive scene generation.

— AI at Meta (@AIatMeta) November 20, 2025

Matt, a SAM 3D researcher, explains how the two-model design makes this possible for both people and complex environments.… pic.twitter.com/wt6wPSmdou

Segment Anything Model 3の特徴・概要

SegmentAnythingModel3はMetaが開発した次世代のセグメンテーション基盤モデルです。

Today we’re excited to unveil a new generation of Segment Anything Models:

— AI at Meta (@AIatMeta) November 19, 2025

1️⃣ SAM 3 enables detecting, segmenting and tracking of objects across images and videos, now with short text phrases and exemplar prompts.

🔗 Learn more about SAM 3: https://t.co/tIwymSSD89

2️⃣ SAM 3D… pic.twitter.com/kSQuEmwH33

従来の画像や動画における物体検出や追跡に加えて、短い文章や参照画像を手がかりに対象を指定できるようになりました。

自然言語で条件を与えるだけで必要な領域を抽出できる柔軟性が大きな特徴です。

また、この技術はSAM3Dの中核を支えるバックボーンとしても活用されています。

参考:Meta公式サイト

3Dプリントが3日で届くサービス『3Dayプリンター』も展開しています。3Dモデリングから3Dプリント・塗装など後加工までサポートします。